Možná jste v posledních dnech zaznamenali kontroverzní humbuk okolo nového plánu firmy Apple o vyhledávání fotek s dětskou pornografií. Celá aféra vyvolala vlnu negativních reakcí, a tak se Apple rozhodnul vydat obsáhlý dokument s často kladenými otázkami, které vše uvádějí na pravou míru.

První ze všeho dokument poukazuje na rozdíly mezi „Communication safety in iMessages” a „Child Sexual Abuse Material” (CSAM). Zatímco první jmenovaná má zabraňovat dětem v odesílání sexuálního obsahu, detekce CSAM se zaměřuje na již uložené fotky na iCloudu, které mohou pomoct dopadnout šiřitele dětské pornografie.

Bezpečnost komunikace v iMessages

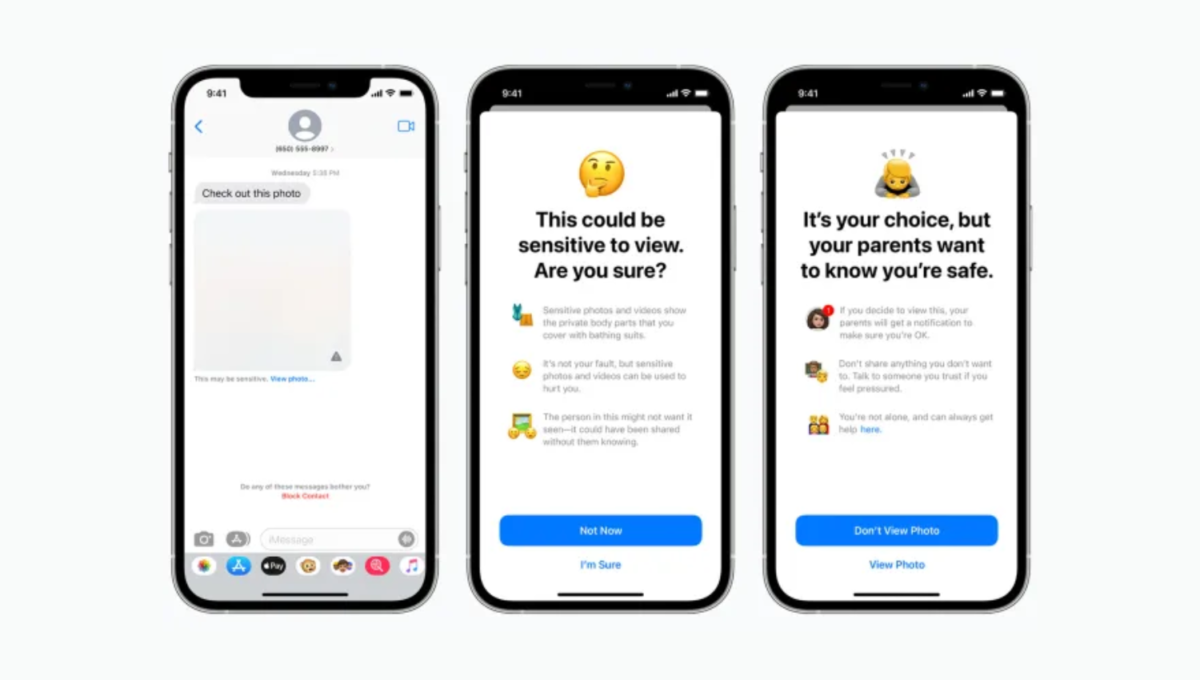

Začněme tedy prvním termínem, kterému se dokument věnuje. Bezpečnost komunikace v iMessages je funkce, která bude aktivovaná pouze v případě, že používaný iCloud účet je zaregistrovaný jako rodinný. Nic se nebude dít automaticky, zapnutí této funkce bude na rodičích. Notifikace o podezřelých komunikacích navíc budou rodičům chodit jen od dětí starých 12 let a mladších.

To hlavní ale je, že všechna upozornění zůstávají mezi rodičem a dítětem. Neodesílají se Applu ani Národnímu centru pro zneužívané a nezvěstné děti (NCMEC). Stejně tak tím Apple nepřeruší end-to-end šifrování zpráv.

V praxi to bude fungovat tak, že pokud dítěti přijde fotka (nebo bude chtít odeslat fotku) s potenciálním sexuálním obsahem, do iMessages přijde rozmazaná. Při pokusu o zobrazení nebo odeslání bude dítě upozorněno, že pokud tak učiní, bude fotka odeslána nejdříve jeho rodiči pro schválení. Zde se ještě dítě může rozhodnout zda tak učiní, či nikoliv – rodič pořád o ničem vědět nemusí. Děti starší 12 let pak sice dostanou upozornění, že se může jednat o sexuální obsah, mohou si jej ale zobrazit či odeslat, ale rodič už žádné upozornění nedostane.

Detekce potenciálního obsahu s dětskou pornografií (CSAM)

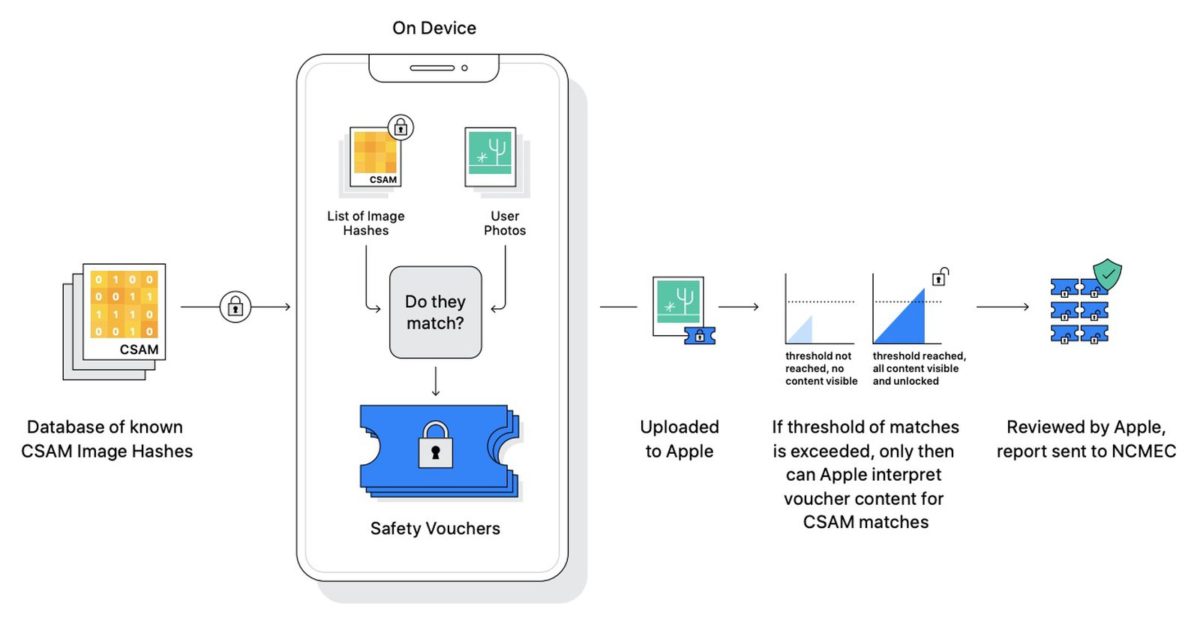

Detekce CSAM je oproti výše popsané funkci úplně jiný příběh. Jedná se o technologii, která dokáže rozpoznat fotky, na kterých by měla být dětská pornografie a následně zamezit jejímu šíření. V tomto případě je vyhledáváno z fotek uložených na službě Fotky iCloud, uživatelé, kteří si nechávají fotky uložené pouze lokálně, tímto ovlivněni nebudou.

Apple vyvinul hašovací technologii schopnou rozpoznat fotky s dětskou pornografií. Tyto haše jsou řady čísel, která reprezentují známé CSAM fotky, ale není možné je překonvertovat na samotné fotografie. Apple navíc vyzdvihuje, že vše opravdu bude probíhat pouze na vašem zařízení a před přezkoumáním se opravdu nic nikam posílat nebude.

Pokud však tato technologie najde fotku s dětským sexuálním obsahem, bude odeslána na přezkoumání člověkem od Applu. Jakmile ale fotka bude usvědčena jako sexuálně závadná i z této strany, Apple bude nucen ji i uživatele nahlásit skupině NCMEC, kde se teprve bude rozhodovat o finálním úsudku. Těmito kroky chce Apple zabránit možnému obvinění nevinných uživatelů.

Jak na tento krok Applu pohlížíte vy? Uklidnily vás trochu tyto odpovědi na často kladené otázky nebo jste pořád v obavě, že Apple nebo vláda bude této funkce zneužívat?

Celý dokument si můžete přečíst ZDE.